Après des mois de débats intenses (et pas mal de lobbying en coulisses), le Règlement Européen sur l’Intelligence Artificielle aka IA Act est enfin en piste depuis août 2024.

Mais attention, les vraies échéances, celles qui vont forcer les entreprises à se conformer, se rapprochent de plus en plus.

Tu te perds un peu dans tout ça ? Alors, voici un décryptage express pour toi en 5 questions.

C’est quoi l’objectif de l’EU AI Act ?

Facile : Une loi pour eviter les dérapages à la Terminator.

Plus sérieusement, l’Europe veut tout simplement :

- Poser un cadre légal pour que l’IA reste « centrée sur l’humain » et qu’elle ne piétine ni les droits fondamentaux ni les libertés individuelles.

- Fixer des barrières (plus ou moins hautes) pour encadrer l’utilisation et la commercialisation de l’intelligence artificielle en Europe.

- Créer un écosystème IA pour garder un œil sur les entreprises, les fournisseurs et les distributeurs d’IA et rassurer le grand public.

Quelles sont les règles du jeu : du risque zéro à « on surveille »

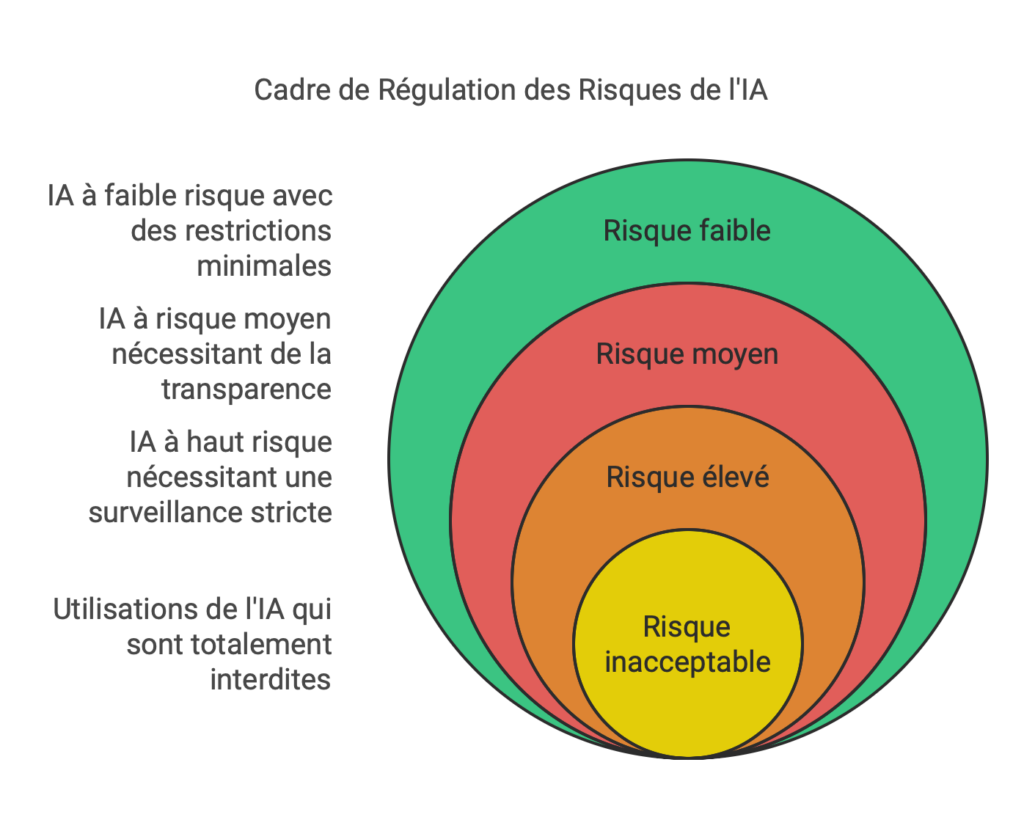

L’IA Act classe les usages de l’IA en 4 grandes catégories :

1. Risque inacceptable : stop direct

Exemples : « Scoring social à usage général, techniques de manipulation cognitivo-comportementale de personnes, surveillance biométrique en temps réel et à distance… »

👉 Verdict : C’est interdit.

Les règles s’appliquent à partir du 2 février 2025.

Mais (parce qu’il y a toujours un « mais »), il existe des exceptions comme d’habitude pour la sécurité publique. Genre, si la police veut utiliser des outils biométriques en temps réel dans les lieux publics, c’est possible, à condition de bien justifier le tout.

2. Risque élevé : check obligatoire

Cas typiques : IA dans la santé, l’éducation, le recrutement, ou la gestion des infrastructures critiques…

👉 Obligations :

- Vérifier que l’outil est safe avant de le lancer.

- Obtenir un marquage CE, sorte de “label CE”.

- Gérer les risques en continu.

- Être prêt à montrer patte blanche si une autorité passe faire un audit.

Si tu développes par exemple une IA qui diagnostique une maladie tu dois prouver qu’elle est sans risque et ne fera pas n’importe quoi : qualité des données, transparence, supervision humaine…

Pour les systèmes d’IA publics, il faut une inscription obligatoire dans une base de données accessible à tous. Ici, c’est à partir du 2 août 2027 que la loi commence à s’appliquer pour ce type d’IA.

3. Risque moyen : transparence exigée

Ici, on parle d’IA comme les chatbots d’entreprises ou les générateurs de contenu qui pourraient manipuler les gens.

👉 Règle d’or : l’utilisateur doit savoir qu’il interagit avec une IA.

4. Risque faible : open bar

Tout le reste (genre ton IA qui trie tes photos de vacances) n’a aucune restriction.

👉 Là, l’UE demande juste de joue fair-play et tout ira bien.

Comment la loi s’applique aux IA type ChatGPT ?

Même s’ils ne sont pas classés à haut risque, les modèles d’IA générative comme GP4-o, o1 ou Midjourney, doivent respecter des règles spécifiques :

- Transparence total : les entreprises doivent déclarer si elles ont pompé du contenu protégé par le droit d’auteur pour entraîner leurs modèles. Plus de secret d’entraînement façon « on ne dévoile pas nos sources ». Mais OpenAI et compagnie ne sont pas contents pour ça.

- Modèles puissants : si un modèle présente un « risque systémique », et peut perdre le contrôle comme skynet, les obligations montent d’un cran : analyse proactive des risques et mitigation obligatoire.

Quoi qu’il en soit, les boîtes concernées ont jusqu’au 2 août 2026 pour se conformer

NB : Une exception pour les projets open source et les modèles en R&D, qui s’en sortent avec des règles allégées (merci les lobbyistes !).

Ah, et si ton modèle dépasse un certain seuil de puissance (mesuré en FLOPS — calcule pas, c’est juste énorme), là ça se complique. Pour l’instant, aucun modèle ne semble concerné, mais qui sait où on en sera d’ici deux ans ?

Alors que se passe-t-il si une entreprise IA ne respecte pas les normes de l’IA Act ?

T’as une boîte qui fait de l’IA ? Gare aux sanctions si tu dérapes.

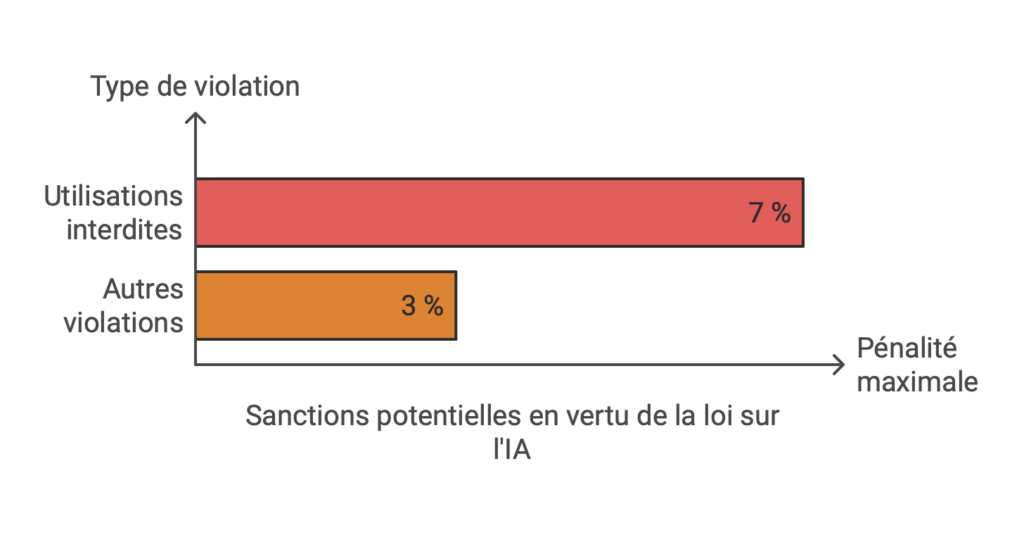

L’Europe a prévu des amendes salées :

- Jusqu’à 7 % du chiffre d’affaires mondial pour les utilisations interdites.

- 3 % pour le reste des violations (genre oublier de transmettre des infos aux autorités). Un « oups » qui coûte cher.

- Et si une IA met vraiment en danger la sécurité des citoyens ? L’interdiction pure et simple est sur la table.

Les entreprises ont combien de temps pour se conformer à l’EU AI Act ?

L’IA Act est entrée en vigueur le 1ᵉʳ août 2024, mais pas de panique : les obligations arrivent par étapes jusqu’en 2027. Ça laisse le temps aux entreprises (et aux régulateurs, soyons honnêtes) de s’organiser.

Puisque l’UE est encore en train de peaufiner des détails (codes de bonne conduite, normes précises, etc.).

Justement, une consultation publique a été ouverte depuis le 13 novembre par l’UE jusqu’au 11 décembre 2024 pour recueillir les avis des parties prenantes afin de finir la rédaction des codes de bonnes pratiques.

Ce qu’il faut retenir

L’EU AI Act, c’est une tentative courageuse de poser des limites dans un monde où l’IA avance plus vite que les législations.

Le côté positif : une régulation pour protéger nos données, nos vies privées et éviter les dérives dystopiques. L’UE montre qu’elle ne rigole pas.

Mauvaise nouvelle : des règles trop lourdes et floues pourraient freiner l’innovation en Europe. Le risque ? Les talents et les boîtes les plus prometteuses peuvent s’expatrier là où les règles sont plus light.

En attendant, développeurs et entreprises doivent s’adapter à l’ EU IA Act. Et si t’as une idée d’IA, mieux vaut anticiper ces règles avant que les régulateurs viennent frapper à ta porte. 😉