L’intelligence artificielle s’infiltre partout, et Meta n’est bien sûr pas en reste.

L’entreprise déploie ses outils de création d’images IA à tout-va, tout en tentant – avec une sincérité grandissante– de renforcer la transparence autour de leur utilisation.

La dernière trouvaille en date ?

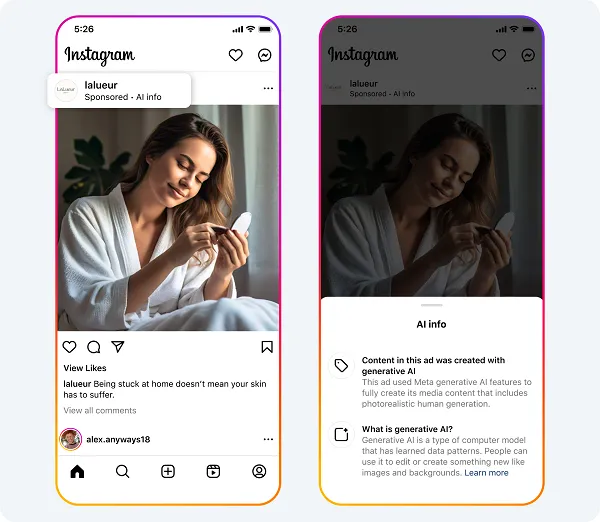

Un système d’étiquetage pour signaler les publicités qui utilisent des images générées ou modifiées par ses propres outils d’IA.

Une idée qui semble vertueuse… jusqu’à ce qu’on regarde les petits caractères en bas du contrat.

Des étiquettes pour plus de clarté… enfin, sur le papier

Meta a commencé à déployer des labels de transparence sur les publicités qui utilisent ses outils d’IA générative.

Ces petits badges sont censés informer les utilisateurs lorsqu’une image ou une vidéo a été créée ou modifiée de manière “significative” par l’IA maison.

« Nos étiquettes sont conçues pour aider les gens à comprendre quand des images et des vidéos ont été créées ou significativement modifiées avec nos outils d’IA générative. » – Meta

Le hic ? Meta ne précise pas ce qu’il entend exactement par “significatif”.

En clair, si une image est juste un peu retouchée ou ne représente pas un humain ultra-réaliste, zou, pas d’étiquette !

Autrement dit, une bonne partie du contenu IA pourrait se faufiler incognito sous le radar.

Belle opération transparence, n’est-ce pas ?

Un vrai pas vers la clarté ?

Si on creuse un peu, on se rend vite compte que cette “transparence” ne s’applique qu’aux publicités utilisant les outils IA de Meta.

Autrement dit, tous les posts classiques des utilisateurs qui innondent Facebook et Instagram de visuels générés par Midjourney, DALL·E ou autres passent à travers les mailles du filet.

Prenons un exemple concret :

Un annonceur utilise l’IA de Meta pour créer une image publicitaire ? Boom, petite étiquette signalant l’usage de l’IA.

Un utilisateur lambda balance un visuel photo réaliste généré par un autre outil IA ? Aucune indication.

Problème : des images trompeuses pullulent déjà sur Facebook et Instagram.

Certains utilisateurs prennent pour argent comptant des visuels créés de toutes pièces par des IA, et ce système d’étiquetage ne résout absolument pas ce souci.

Une transparence à la carte, ça vous dit quelque chose ?

Et les autres outils d’IA ? Meta y pense… un jour, peut-être

Meta nous rassure : l’entreprise “réfléchit” à une solution pour les images créées par d’autres outils IA.

Elle promet de “partager plus d’informations sur son approche de l’étiquetage des images IA non-Meta” dans le courant de l’année.

Oui, oui. Comme toujours, Meta adore prendre son temps quand il s’agit de mesures de transparence.

Historiquement, l’entreprise réagit souvent après que le problème ait explosé, et pas avant.

Mais soyons optimistes : peut-être qu’un jour, une véritable régulation finira par voir le jour.

En attendant, accroche-toi et essaie de deviner tout seul ce qui est réel ou généré.

Mon avis : une transparence à géométrie variable, comme d’hab’

L’initiative de Meta est un pas en avant, mais honnêtement : c’est un tout petit pas, et surtout dans la direction qui arrange Meta.

Tant que les images IA postées par les utilisateurs classiques ne seront pas signalées, la confusion régnera toujours sur Facebook et Instagram.

On le sait : Meta fait avant tout ce qui l’arrange.

En limitant l’étiquetage aux publicités créées avec ses propres outils, l’entreprise se donne une image de transparence sans trop impacter l’engagement (et donc ses revenus).

Parce qu’un Facebook où chaque image douteuse est marquée d’un label “IA” perdrait probablement un peu de sa magie virale.

Alors, Meta joue-t-il vraiment la carte de la transparence ou nous sert-il un coup de communication bien rodé ? À toi de juger.

Et pendant que tu y réfléchis, partage cet article pour voir si ton entourage tombe encore dans le panneau des images IA sans le savoir… 😉