Vous vous demandez comment les algorithmes Google influencent réellement vos résultats de recherche ? Cet article vous révèle les dessous de NearestSeed et NavBoost, ces mécanismes discrets mais primordiaux du moteur.

On va décortiquer ensemble leur impact sur l’expérience utilisateur et vous montrer comment adapter vos sites web. L’astuce ?

Analyser finement les clics et les parcours des visiteurs pour booster la pertinence des résultats. Un vrai changement de perspective pour qui veut vraiment comprendre les rouages du référencement !

Les piliers méconnus de l’écosystème Google

Rôle central des algorithmes dans la recherche web

C’est un fait : les algorithmes Google déterminent en grande partie le classement de vos pages.

Une mécanique complexe où chaque paramètre SEO compte, du contenu au maillage interne.

NearestSeed et NavBoost : des rouages discrets

Connaissez-vous NearestSeed et NavBoost ? Ces deux algorithmes travaillent dans l’ombre pour améliorer votre référencement.

Bien moins médiatisés que Panda ou Penguin, ils influencent pourtant directement la visibilité des sites.

David Licoppe

Voyons ce qui les rapproche :

- Données utilisateurs : Ils exploitent les comportements de navigation (durée de session, taux de rebond…) pour ajuster le PageRank en temps réel. Une approche qui rappelle le fonctionnement de RankBrain.

- Expérience utilisateur : Comme avec l’update Mobilegeddon, ils privilégient les pages optimisées pour tous les devices. Le temps de chargement et l’accessibilité deviennent des critères-clés.

- Adaptabilité : Ces systèmes évoluent constamment – à l’image des mises à jour Penguin contre le spam. Ils s’ajustent aux nouvelles tendances comme la recherche vocale ou le SEO local.

- Qualité : Leur but ? Filtrer les contenus pauvres, à la manière de Panda. Ils valorisent l’expertise éditoriale et les backlinks naturels issus de domaines autoritaires.

- Contexte : Comme BERT, ils analysent l’intention derrière chaque requête. Une recherche « chaudière » n’affichera pas les mêmes résultats selon qu’elle provient d’un plombier ou d’un particulier.

En somme, ces mécanismes illustrent la philosophie Google : récompenser les sites qui offrent une valeur ajoutée réelle à leurs utilisateurs.

L’évolution historique des mécanismes de classement

Saviez-vous que le premier PageRank date de 1996 ? Depuis, chaque mise à jour (Panda, Penguin, Hummingbird…) a renforcé l’importance du SEO naturel face aux techniques abusives.

Aujourd’hui, RankBrain et les IA de traitement du langage dominent. Mais les fondamentaux restent : un domaine crédible, un contenu optimisé et une expérience utilisateur irréprochable font toujours la différence dans les SERPs.

Rôle central des algorithmes dans la recherche web

Pourquoi certains sites trustent-ils les premières positions ? La réponse tient à leur maîtrise des critères algorithmiques. Un bon référencement passe par l’analyse fine des données de Search Console et l’adaptation aux évolutions comme Core Web Vitals.

NearestSeed et NavBoost : des rouages discrets

Ces algorithmes méconnus jouent pourtant un rôle-clé dans le SEO moderne. NavBoost analyse par exemple les CTR sur 13 mois – une donnée précieuse pour ajuster vos balises title et meta descriptions. Quant à NearestSeed, il influence directement la propagation du PageRank au sein de votre réseau de backlinks.

Un conseil : traitez ces mécanismes comme des alliés plutôt que des boîtes noires. En optimisant votre architecture technique et votre contenu pour l’humain avant les robots, vous tirerez naturellement parti de ces systèmes complexes.

NearestSeed : comment Google identifie les sources fiables

Fonctionnement technique et identification des « graines »

Voici un tableau comparatif des critères de sélection des seeds par NearestSeed (NS) et du classement standard :

| Critères | Classement Standard | NearestSeed (NS) |

|---|---|---|

| Facteurs principaux | Qualité du contenu, mots-clés, liens, expérience utilisateur. | Pertinence, fiabilité, autorité du contenu. |

| Qualité du contenu | Évaluée via l’algorithme Panda (intégré à l’algorithme principal). | Privilégiée comme base de la crédibilité et de la pertinence. |

| Indicateurs de qualité | Non spécifié en détail. | Citations académiques/institutionnelles, profondeur du contenu, liens entrants/sortants de qualité, réputation auprès des utilisateurs, cohérence thématique. |

| Évaluation de l’autorité thématique | Non spécifiée en détail. | Analyse de la profondeur et de l’étendue du contenu, examen des liens, évaluation de la réputation. |

| Liens sortants | Non spécifié en détail. | Vers des sources de qualité, indiquant une recherche d’informations complètes et précises. |

Légende : Ce tableau compare les criteres utilisés par l’algorithme de classement standard de Google et l’algorithme NearestSeed (NS) pour évaluer et classer les pages web. On remarque que NS accorde plus d’importance à la qualité des sources qu’au simple respect des bonnes pratiques SEO.

D’ailleurs, la cartographie des domaines en référencement naturel n’a rien d’une science exacte. L’évaluation de l’autorité thématique par NearestSeed repose sur un savant mélange entre le PageRank historique et des signaux plus récents comme RankBrain. Les liens sortants vers des ressources académiques ?

Un excellent moyen de booster sa crédibilité tout en évitant le spam.

David Licoppe

Impact sur le référencement naturel des sites spécialisés

Pour les niches thématiques, devenir une « seed » offre un avantage concurrentiel majeur. Voyons concrètement : créer du contenu de qualité SEO nécessite de maîtriser à la fois les fondamentaux (Panda, Penguin) et les nouveaux critères comme la profondeur sémantique.

Un bon équilibre entre mots-clés et expertise naturelle, en somme.

Cas pratiques d’optimisation pour NS

Alors comment adapter ses contenus ? La densité informationnelle idéale n’est pas officiellement révélée, mais on peut deviner certaines tendances. Par exemple, une page bien structurée avec des références institutionnelles aura plus de poids qu’un simple article de blog superficiel.

C’est là que Penguin intervient pour filtrer les tentatives de manipulation.

Quant aux signaux sociaux, ils jouent un rôle indirect mais non négligeable. Une étude partagée par des experts du domaine aura plus d’impact qu’un tweet viral éphémère.

L’algorithme RankBrain semble d’ailleurs accorder une attention particulière à ces marqueurs de notoriété durable.

NavBoost : quand Google écoute vos clics

Analyse des comportements de navigation

Saviez-vous que vos clics influencent directement le référencement ? NavBoost scrute méticuleusement les interactions utilisateurs – notamment via les données de clics – pour évaluer la qualité des pages web. Cet algorithme conserve même un historique de 13 mois ! Une mémoire longue qui permet à Google d’affiner ses résultats en fonction des tendances réelles.

Le secret ? Une adaptation permanente. Le moteur de recherche ajuste ses critères pour coller aux évolutions technologiques et comportementales.

Prenez Chrome : il analyse la fréquence des requêtes et leur corrélation avec les clics. Résultat, NavBoost booste les pages qui répondent vraiment aux attentes des internautes. C’est tout l’enjeu du SEO moderne !

UX optimale = SEO boosté

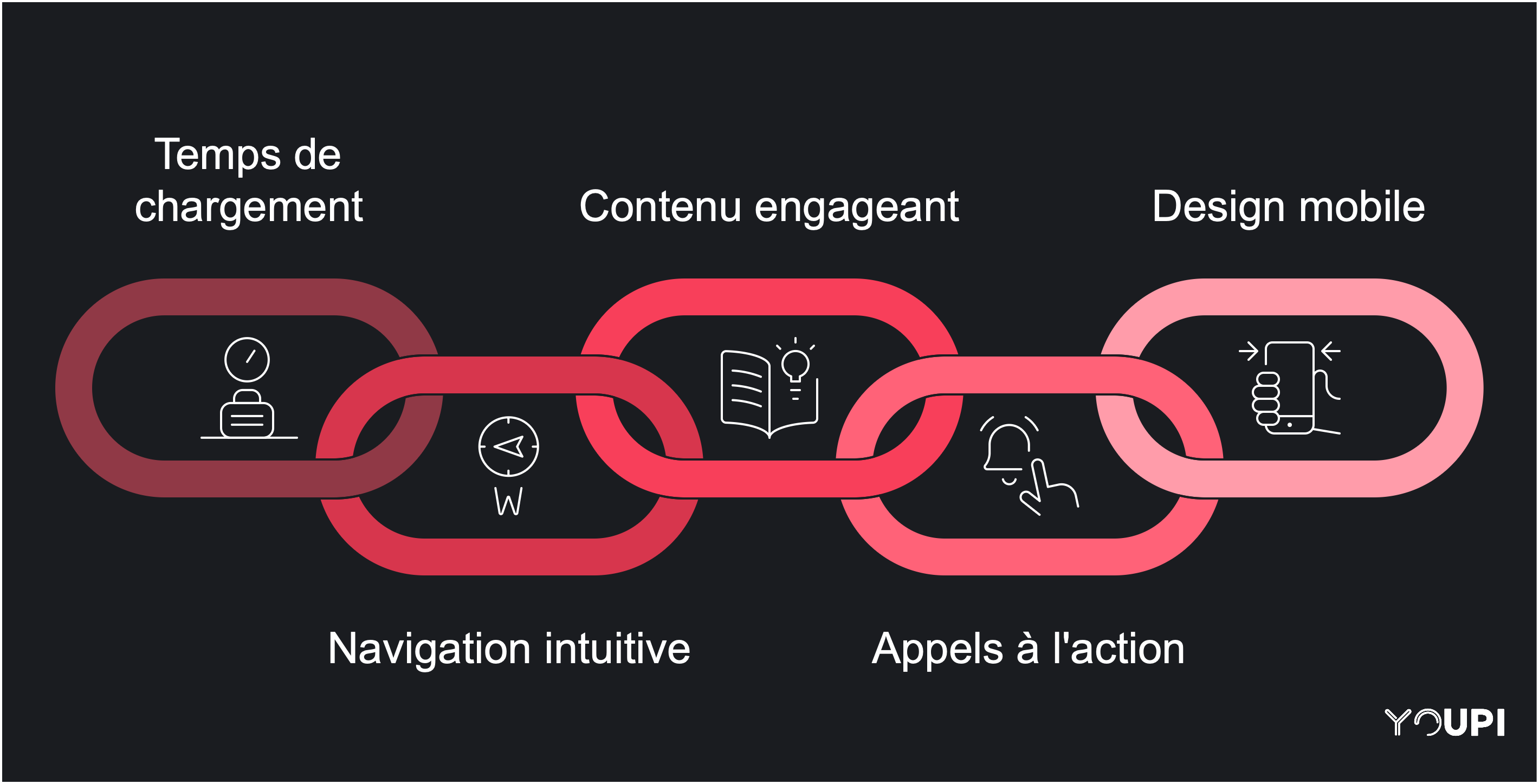

Pour tirer parti de NavBoost, l’expérience utilisateur devient primordiale. Voyons comment concilier algorithmes et comportements humains :

- Temps de chargement : Un site lent, c’est souvent la garantie d’un taux de rebond élevé. Optimisez chaque image, chaque script… Vos visiteurs (et Google Penguin) vous remercieront.

- Navigation intuitive : Pensez architecture logique et liens internes pertinents. Une hiérarchie claire améliore l’exploration des pages tout en fluidifiant le crawl des robots.

- Contenu engageant : Ici, Google Panda veille au grain. Privilégiez les textes naturels et informatifs qui génèrent du temps passé sur site. Les partages sociaux deviennent alors un excellent signal SEO.

- Appels à l’action : Des CTA bien placés guident les utilisateurs tout en augmentant l’engagement. Un bon équilibre entre conversion et expérience naturelle, voilà la clé !

- Design mobile : Avec l’essor du mobile-first indexing, un site responsive n’est plus optionnel. Pensez aux micro-interactions qui rendent la navigation tactile plus agréable.

- Lisibilité : Espacements, typographie, contraste… Ces détails font la différence entre un contenu qui convertit et une page qui rebute. RankBrain adore les contenus bien structurés !

En appliquant ces principes, vous travaillez simultanément pour vos visiteurs et pour les algorithmes comme Panda ou Penguin. Une stratégie gagnant-gagnant qui améliore à la fois votre référencement naturel et votre domaine authority.

Dernier point crucial : l’articulation entre architecture technique et performance SEO. NavBoost récompense les sites où l’information circule fluidement, tant pour les robots que pour les humains. Un bon PageRank commence toujours par une expérience utilisateur irréprochable !

Comment les algorithmes Google collaborent intelligemment

La danse subtile entre NS, NavBoost et leurs acolytes

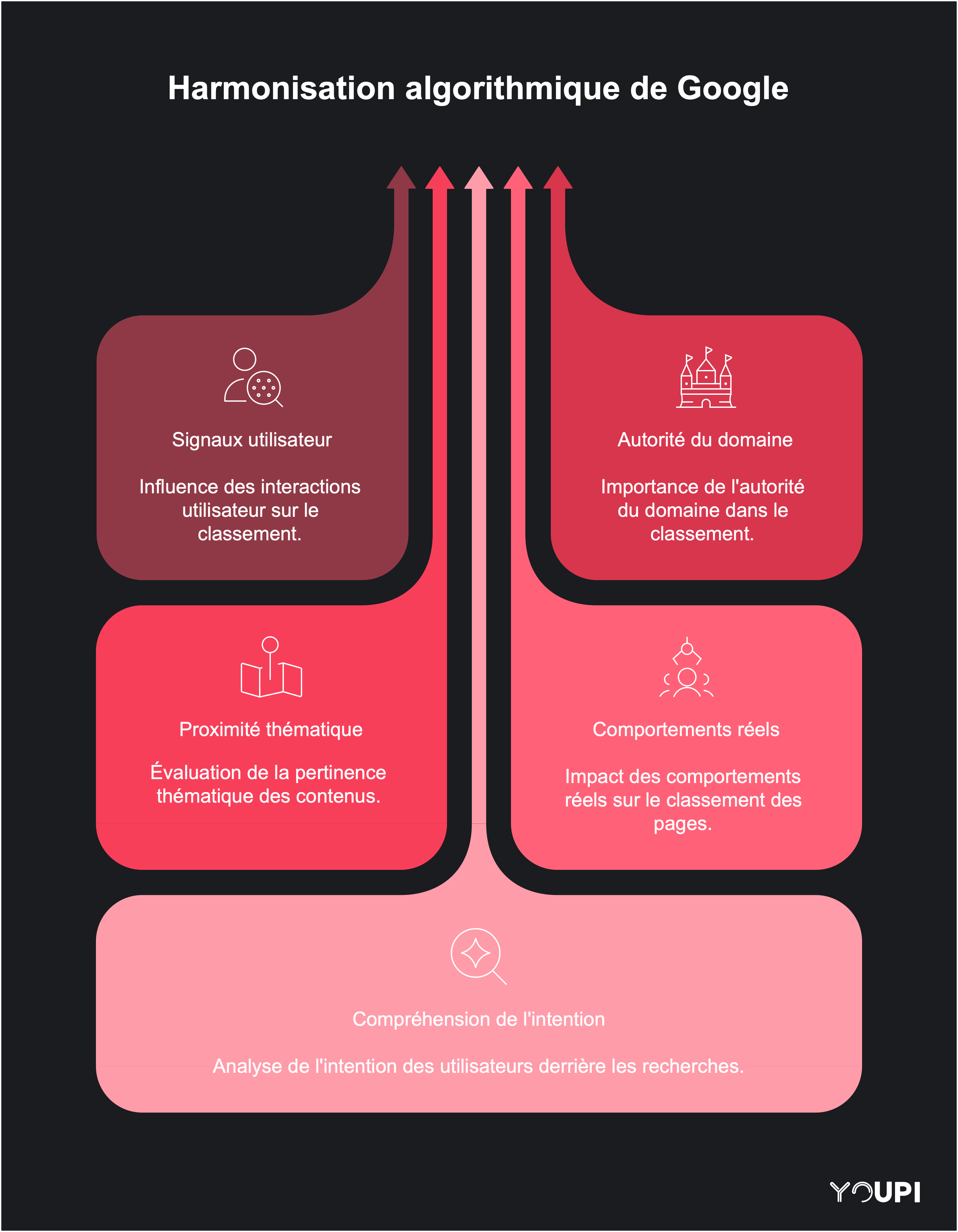

Voyons comment Google priorise ses signaux. Le moteur de recherche utilise un système de pondération sophistiqué pour arbitrer entre les différents scores algorithmiques. Cette mécanique détermine quelle donnée devient déterminante selon le contexte de la requête et le profil du utilisateur.

Prenons l’exemple de NavBoost : ce système observe en direct les clics et interactions réelles pour ajuster le classement des pages. Une vraie boucle de rétroaction qui s’enrichit de chaque visite ! Saviez-vous qu’il dialogue constamment avec Panda et Penguin pour filtrer le spam tout en boostant les contenus naturels ?

Le secret réside dans cette complémentarité. NS agit comme un GPS pour évaluer la proximité thématique, tandis que NavBoost apporte la touche humaine via les comportements réels. Ensemble, ils alimentent le Pagerank moderne en tenant compte à la fois de l’autorité du domaine et des signaux utilisateurs. C’est ce mélange qui fait la force du referencement naturel aujourd’hui.

D’ailleurs, RankBrain joue les médiateurs dans cet écosystème. En analysant les recherches complexes, il aide les autres algorithmes à mieux comprendre l’intention cachée derrière les mots-clés. Une vraie symbiose technologique au service de l’expérience utilisateur !

Stratégies SEO pour les algorithmes de nouvelle génération

Approche holistique de l’optimisation

Intégrer les contraintes NS/NavBoost dans votre production éditoriale, c’est repenser l’approche SEO traditionnelle. Pour vraiment tirer son épingle du jeu face à des algorithmes comme Panda ou Penguin, une vision globale s’impose. Concrètement ? Il s’agit de comprendre comment ces systèmes évaluent à la fois la qualité des pages et le parcours utilisateur.

Un site bien structuré, avec une navigation intuitive, aura toujours un coup d’avance sur le référencement naturel. Pensez-y : Google adore les sites où l’on se repère facilement, surtout pour les recherches de type « navigation » (comme trouver un service précis).

Mais comment mesurer l’efficacité réelle ? Tournez-vous vers des indicateurs clés comme le taux de clics dans les résultats de recherche ou le temps passé sur la page. Ces KPI en disent long sur l’impact de vos optimisations. Par exemple, un CTR en hausse signifie que votre méta titre accrocheur fonctionne. Quant au temps de lecture, il reflète directement la qualité perçue de votre contenu par RankBrain. À ne pas négliger non plus : le taux de rebond, qui peut trahir un problème d’expérience utilisateur.

Éviter les pièges courants

Attention aux pièges de la suroptimisation ! Google n’hésite plus à sanctionner les techniques douteuses – rappelez-vous les mises à jour Panda contre le contenu spam ou Penguin pour les liens artificiels.

Le bourrage de mots-clés, les textes dupliqués… Autant de pratiques risquées qui peuvent plomber votre pagerank.

La clé ?

Trouver ce point d’équilibre où l’optimisation technique sert l’expérience réelle, sans tomber dans l’excès.

Mais comment trouver le juste équilibre ? Priorisez toujours l’humain derrière l’écran. Un bon référencement naturel, c’est d’abord du contenu utile, bien structuré et facile à lire – et à partager. Pensez mobile, vérifiez la vitesse de chargement, soignez votre maillage interne.

Ces fondamentaux, combinés à une analyse régulière de votre domaine authority, constituent votre meilleure parade contre les aléas des mises à jour algorithmiques.

Le SEO moderne exige un savant dosage entre expertise technique et authenticité éditoriale.

L’avenir des algorithmes de recherche

Influence de l’IA générative

L’intégration des modèles de langage aux algorithmes existants devient un enjeu majeur pour améliorer le référencement naturel. Grâce au NLP, des outils comme Google arrivent désormais à interpréter finement l’intention derrière vos recherches, ce qui change la donne pour le SEO. Un progrès qui rappelle l’impact qu’ont eu Panda ou Penguin sur le classement des pages web.

Mais attention, cette convergence ne va pas sans défis. Prenons l’exemple du biais algorithmique : quand le machine learning reproduit des discriminations présentes dans ses données d’entraînement, ça se ressent directement sur les résultats.

Certaines pratiques de spam ressurgissent même, boostées par des modèles trop focalisés sur l’engagement immédiat. Résultat : des pages bien optimisées mais peu pertinentes peuvent se hisser abusivement en tête.

Voyons comment Google tente de contrebalancer ça. L’IA générative vient compléter des outils comme Penguin pour évaluer la qualité réelle du contenu.

Une avancée qui devrait renforcer l’équité du référencement naturel, à condition de maîtriser les biais économiques et statistiques. Un défi de taille pour les spécialistes du SEO, vous ne trouvez pas ?

Retours d’expérience et analyses sectorielles

Études de cas transversales

Le benchmark de stratégies SEO vraiment efficaces pour NS/NavBoost s’avère déterminant. NearestSeed (NS) et NavBoost sont des algorithmes de Google qui jouent un rôle important dans le classement des pages et l’expérience de recherche reste souvent sous-estimée.

L’analyse comparative entre différentes régions du globe apporte des enseignements précieux. Prenons NavBoost : ce système de classement utilise les clics des internautes pour ajuster les résultats en temps réel. L’algorithme Navboost prend en compte des indicateurs tels que le temps de visite, le taux d’interaction et la fidélisation des utilisateurs. D’ailleurs, son rôle a été confirmé lors du récent procès antitrust – et le Google Leak l’a remis au centre des débats SEO. Une particularité intéressante ?

Ces mécanismes s’adaptent constamment aux comportements des utilisateurs, ce qui implique des stratégies SEO différenciées selon les marchés.

Méthodologies et outils d’analyse

Stack technologique pour le monitoring algorithmique

Le panorama des solutions logicielles dédiées est important. Pour mesurer l’impact de NavBoost, une surveillance régulière des KPI s’impose. Saviez-vous que l’algorithme NavBoost de Google analyse en temps réel les interactions des utilisateurs pour ajuster les SERP, remodelant constamment les pages de résultats selon les données de clics.

Voyons comment interpréter ces données. Le défi ? Distinguer l’influence de chaque système qui interagissent en permanence. Une astuce : comparez les variations de classement avant/après les mises à jour d’algorithmes. En croisant ces éléments avec l’historique de votre domaine, vous isolerez progressivement l’impact spécifique de NavBoost.

C’est d’ailleurs ce qui explique pourquoi certaines pages remontent dans les recherches sans modification technique apparente – le trafic naturel faisant souvent la différence.

En maîtrisant les algorithmes Google NearestSeed et NavBoost, vous saisissez mieux l’impact des sources fiables combiné à l’expérience utilisateur.

Un bon SEO nécessite justement cet équilibre – affinez-le progressivement pour un référencement pérenne et une visibilité qui tient la distance.

Le web de demain se construit aujourd’hui : et si vous en étiez l’un des artisans ?