Un samedi ordinaire transformé en chaos : le PDG de Triplegangers, Oleksandr Tomchuk, se réveille avec une alerte terrifiante. Son site e-commerce est hors service.

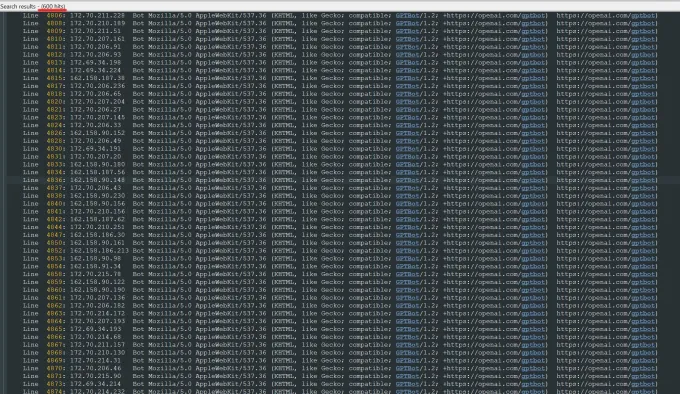

La raison : une activité qui ressemble à s’y méprendre à une attaque DDoS.

Mais l’ennemi n’est pas un hacker anonyme, c’est un bot d’OpenAI.

Pour rappel, Triplegangers est une petite entreprise ukrainienne de sept personnes spécialisée dans la vente des modèles 3D hyper détaillés d’êtres humains. La société a mis plus d’une décennie à bâtir sa base de données de plus de plus de 65 000 produits.

Chaque modèle 3D est minutieusement détaillé, avec des infos sensibles comme l’origine ethnique, des tatouages ou des cicatrices. Autant dire que pour des entreprises comme OpenAI, c’est le jackpot pour entraîner leurs IA.

Résultat : Des dizaines de milliers de requêtes simultanées, des centaines de milliers de fichiers aspirés… et un site KO technique.

Et comme si ça ne suffisait pas, le robot utilise plus de 600 adresses IP.

Des conséquences bien réelles pour une petite entreprise

Cette mésaventure ne s’arrête pas au plantage du site.

Tomchuk s’attend à une facture AWS salée pour l’activité serveur générée par le bot.

Mais le plus inquiétant, c’est qu’il n’a aucun moyen de savoir ce qu’OpenAI a récupéré ni de leur demander de supprimer ces données.

La société de Sam Altman n’a pas même pas répondu aux sollicitations de l’entreprise.

Et quand on sait que Triplegangers gère des données sensibles, comme des photos 3D de personnes réelles, on comprend l’ampleur du problème.

Avec des lois comme le RGPD, l’usage abusif de ces données collectées sans consentement pourrait entraîner de lourdes conséquences juridiques.

Un modèle qui frôle le racket

Ce genre de pratique, c’est un peu comme un système mafieux : si tu ne protèges pas ton site avec un fichier robots.txt ou des balises spécifiques, tu te fais voler.

Et même avec ces protections, rien n’est garanti : tout repose sur la bonne foi des entreprises d’IA, qui peuvent les ignorer tout bonnement.

Certaines, comme Perplexity, ont déjà été pointées du doigt pour ne pas les respecter. Et apparemment OpenAI aussi n’est pas en reste.

Et Triplegangers n’est pas un cas isolé. Une étude de 2024 menée par DoubleVerify révèle une augmentation de 86 % du trafic non valide à cause des bots IA.

De nombreux sites, en particulier des petites entreprises, ne savent même pas qu’ils se font aspirer leurs données.

Le plus drôle, c’est que si GPT Bot avait exploré le site de manière plus discrète, Triplegangers n’aurait probablement jamais été remarqué.

« C’est effrayant de penser qu’ils agissent comme ça, à découvert », confie Tomchuk à Techrcrunch.

À qui la faute ?

Cette histoire met en lumière deux problèmes importants :

- Le système opt-out : Les bots devraient demander la permission avant d’explorer un site, pas l’inverse. Cette approche actuelle met toute la charge sur les petites entreprises, qui n’ont ni les moyens techniques ni le temps de se protéger efficacement.

- L’absence de régulation claire : Tant que l’IA ne sera pas encadrée avec des lois concrètes, ces incidents vont continuer. Et c’est toujours les plus petits qui trinquent.

Ce qu’on en pense

Cette mésaventure illustre un problème systémique. L’IA évolue vite, mais les garde-fous juridiques peinent à suivre.

Même si des efforts sont faits par exemple en Europe avec l’IA Act, il y a encore beaucoup à faire.

Si les entreprises comme OpenAI continuent d’aspirer des données des sites web sans autorisation, elles risquent de se heurter davantage à une levée de boucliers.

Ironiquement, OpenAI avait annoncé un outil nommé Media Manager, censé permettre aux créateurs de mieux gérer leurs données et d’autoriser ou non leur usage par l’IA. Mais à ce jour, aucune trace de cet outil.

L’avenir de l’IA ne peut pas reposer sur des pratiques de quasi-racket.

OpenAI, Perplexity et les autres doivent montrer l’exemple. Demander la permission, respecter les droits d’auteur, et surtout, assumer la responsabilité des dégâts causés.

Mais on peut toujours rêver.